Überregulierung und Innovationsbremse oder eine echte Chance für europäische Softwareentwickler auf einheitliche Wettbewerbsbedingungen? Die KI-Verordnung zur Regelung der Entwicklung und des Einsatzes von KI in der Europäischen Union wurde schon vor der einstimmigen Zustimmung durch die 27 EU-Mitgliedsstaaten heiß diskutiert. Auch im Arbeitsforschungsprojekt PerspektiveArbeit Lausitz setzen wir uns damit auseinander. Warum das notwendig ist, worum es konkret in der Verordnung geht und welche Auswirkungen sie auf KI-Entwicklungen für Unternehmen hat, darüber haben wir mit Stefanie Baade, Stellvertretende Geschäftsführerin des KI-Bundesverbandes, und Max Just, Wirtschaftsjurist beim DID – Dresdner Institut für Datenschutz und Co-Leiter des Arbeitskreises Security & Privacy beim Silicon Saxony e.V. gesprochen.

Frau Baade, die KI-Verordnung muss nicht in nationales Recht umgewandelt werden, sondern gilt ähnlich wie die DSG-VO in den einzelnen EU-Ländern direkt ab Verabschiedung, also seit dem 21. Mai 2024. Was sollte die erste Handlung von Unternehmen sein?

Stefanie Baade: In einem ersten Schritt gilt es zu klären, ob und in welchem Rahmen das jeweilige Unternehmen von der neuen KI-Verordnung betroffen ist. Auch wenn dieser Schritt auf den ersten Blick logisch erscheint, ist die Klärung dieser Frage in der Realität oft nicht einfach. Dazu gehört beispielsweise auch die Einordnung der eigenen Produkte und Dienstleistungen in die entsprechende Risikokategorie des AI Act. Dieser Prozess ist entscheidend, um zu verstehen, welche spezifischen Regulierungen und Compliance-Anforderungen für das eigene Unternehmen relevant sind. Gerade im Hochrisikobereich handelt es sich um sehr detaillierte Anforderungskataloge, die erfüllt werden müssen. Eine frühzeitige Auseinandersetzung mit den konkreten Anforderungen ist daher unabdingbar.

Das scheint gar nicht so leicht zu sein. Was genau ist in der praktischen Umsetzung unter der Definition von KI denn zu verstehen?

Stefanie Baade: Die in der Verordnung festgelegte Definition von KI stellt für uns in der praktischen Umsetzung tatsächlich noch eine Herausforderung dar und wirft weiterhin Fragezeichen auf. Die Defi0nition ist in ihrer Form sehr weit gefasst und beschreibt aus unserer Sicht eher die Eigenschaften von fortgeschrittener Software wie KI. Die Europäische Kommission und das bei ihr angesiedelte AI Office haben nun aber die Aufgabe, anhand einer Auflistung beispielhafter Anwendungen darüber zu informieren, welche KI-Anwendungen konkret unter den AI Act nach Art. 3(1) fallen und als KI-Anwendung im Sinne der KI-Verordnung gelten. Angesichts des Zeitplans für die Umsetzung des AI Act ist davon auszugehen, dass diese Klarstellung noch in diesem Jahr veröffentlicht wird.

Welche KI-Anwendungen im Unternehmen sollte man sich aus Ihrer Sicht denn besonders sorgfältig ansehen, Herr Just?

Max Just: Gerade im Bereich HR-Management wurden aus meiner Sicht KI-Systeme durchaus zu schnell, das heißt ohne fundierte technische und juristische Bewertung, zum Beispiel für das Bewerbungsmanagement eingesetzt. Hier erfolgt eine Verarbeitung teils sensibler personenbezogener Daten, d.h. schon mit Blick auf die bereits bestehende DS-GVO ist fragwürdig, ob solche Systeme immer gesetzeskonform eingesetzt werden können, beispielsweise in Bezug auf eine automatisierte Entscheidungsfindung. Auch für diese Systeme erfordert die KI-Verordnung nun eine genaue Prüfung der potenziellen Risiken der Datenverarbeitung. Um rechtssicher zu agieren, müssen Unternehmen sich – gegebenenfalls mit Unterstützung des Anbieters – z.B. fragen, ob die vom System getroffenen Entscheidungen potenziell negative Auswirkungen auf einzelne Personen haben können. Ohne eine Prüfung durch einen Menschen dürfen Unternehmen jedenfalls die KI nicht allein Entscheidungen treffen lassen, die für die Betroffenen erhebliche Beeinträchtigungen darstellen können. Das ist an sich gar nicht neu, denn diese Anforderung gibt es schon seit 2018 auf Basis der DSG-VO, aber die KI-Verordnung bringt nun zusätzliche Anforderungen, unter anderem auch eine grundrechtliche Folgenabschätzung für Hochrisiko-KI.

Generell gilt: als Entwickler oder Anbieter einer KI-Anwendung wird man es schwer haben, wenn man nicht zumindest in Grundzügen erklären kann oder möchte, wie die KI funktioniert, nach welchen Kriterien sie sich richtet oder welche Trainingsdaten benutzt worden sind.

Zuletzt gab es zunehmend Diskussionen um sogenannte BIAS in KI, also das Phänomen, dass Algorithmen eine Vorliebe für bestimmte Ergebnisse zeigen. Verursacht wird dies durch die Daten, mit denen die Algorithmen trainiert wurden – das kann bewusst oder unbewusst passiert sein. Denkbar ist zum Beispiel, dass bereits die Daten, mit denen eine KI trainiert wird, Vorurteile aufweisen. Aber auch Fehler in der Programmierung oder im Design können zu einem Bias führen. Hat z.B. eine im Bewerbungsverfahren eingesetzte KI einen Bias gegen bestimmte Personengruppen, besteht das Risiko der Diskriminierung. Frau Baade, wie will der AI Act das verhindern?

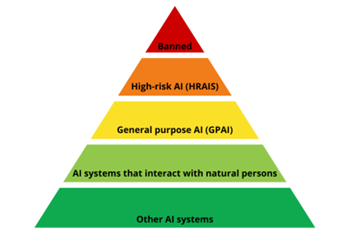

Stefanie Baade: Der AI Act strukturiert KI-Systeme in vier Risikokategorien: inakzeptabel, hoch, begrenzt und minimal. Systeme mit inakzeptablen Risiken, die fundamentale Sicherheiten und Rechte bedrohen – beispielsweise durch staatliche soziale Bewertungssysteme, also sogenannte Social Scoring-Anwendungen, sind nicht zulässig. Hochrisiko-Systeme, etwa in kritischen Infrastrukturen oder in der Finanzbranche für Kreditwürdigkeitsprüfungen, müssen strengen Regulierungen folgen, die eine umfassende Risikobewertung, hohe Datenqualität, ausführliche Dokumentation, Transparenz, menschliche Überwachung und Präzision sicherstellen. Bei Systemen mit begrenztem Risiko, wie Chatbots, ist Transparenz geboten, sodass Nutzer verstehen, dass sie mit einer Maschine und nicht mit einem Menschen interagieren. Niedrigrisiko-Systeme, darunter Spiele und Spamfilter, sind von solchen Auflagen weitgehend befreit, unterstützen jedoch durch ihre freie Nutzung die technologische Entwicklung und Innovation. Zusätzlich gibt es noch eine “fünfte” Kategorie, welche sich aber im Unterschied zu den vorherigen vier nicht am Risiko orientiert, sondern pauschal alle “General Purpose AI”-Systeme umfasst.

Herr Just, was bedeutet das z.B. auf die vorhin diskutierten HR-Tools?

Max Just: Wenn beispielweise die KI aufgrund von BIAS eine Frau aussortiert, die sich auf eine Stelle bewirbt, verstößt die KI gegen geltendes Recht. Wobei ich sagen muss, dass hier auch ohne KI-Verordnung mittels einer sogenannten Datenschutz-Folgeabschätzung, die bei der Entwicklung und Nutzung laut DS-GVO regelmäßig erforderlich ist, eigentlich solche Aspekte bereits geprüft hätten werden müssen. Hier lohnt sich also ein Blick in die vorhandenen Unterlagen bzw. eine Aufarbeitung gemeinsam mit dem Anbieter der KI.

Wenn ich als Unternehmen jetzt feststelle, dass die KI-Anwendung, die ich gerade entwickle oder implementiere, z.B. im Bereich Personalmanagement, in die Kategorie „hohes Risiko“ fällt, welche Schritte sollte ich dann unternehmen?

Max Just: In der Regel wird das Anwendungen betreffen, die personenbezogene Daten verarbeiten. Hierfür galt für implementierende Unternehmen vorher schon laut DS-GVO, dass regelmäßig – gegebenenfalls mit Unterstützung des Anbieters – eine Datenschutz-Folgeabschätzung vorgenommen werden muss. Die Ergebnisse dieser können nun auch in die grundrechtliche Folgenabschätzung einfließen. In jedem Fall ist zunächst die bisherige Dokumentation zu prüfen und im Zweifel nachzujustieren. Das heißt im Übrigen nicht, dass ich jetzt als Anbieter von KI-Anwendungen Geschäftsgeheimnisse zur Funktionsweise verraten muss, indem ich gegenüber den implementierenden Unternehmen offenlege, wie die Algorithmen konkret funktionieren. Aber ich muss darstellen können, welche Informationen wie verarbeitet und bewertet werden. Wenn ich als entwickelndes oder implementierendes Unternehmen für die Anfertigung von erforderlichen Dokumentationen externe Unterstützung benötige, dann empfehle ich, spezialisierte Juristen hinzuzuziehen, z.B. aus dem Bereich Technologie-Recht. Noch besser ist es, wenn ich als implementierendes Unternehmen mindestens eine Person habe, die sich mit dem Thema KI im Detail auskennt und die KI im Idealfall sogar selbst entsprechend prüfen und bewerten kann. Wenn ich ein externes KI-Produkt kaufe, dann sollte der Verkäufer mir auf jeden Fall nachweisbar bestätigen, dass das Produkt der KI-Verordnung entspricht. Der Anbieter ist zudem laut KI-Verordnung unter bestimmten Voraussetzungen dazu verpflichtet, für Hochrisiko-KI eine Konformitätsbewertung vorzunehmen.

Was bedeutet das denn für Forschungsprojekte wie PerspektiveArbeit Lausitz?

Max Just: Bei Forschungsprojekten kann es sinnvoll sein, von vornherein juristische Expertise zu involvieren. Aktuell gibt es in der Verordnung zwar Sonderregelungen für die Entwicklungsphase, aber schließlich sollte das Ziel sein, dass am Ende ein Produkt entsteht, das in der Praxis tatsächlich genutzt werden kann und für das die Fördermittel somit sinnvoll eingesetzt wurden.

Mehr zum Thema können Sie hier im Podcast von Silicon Saxony mit Stefanie Baade anhören.